Atapuerca

La Sierra de Atapuerca, conjunto montañoso que está situada al norte de la provincia de Burgos, ha cobrado importancia a lo largo del tiempo gracias a los importantes hallazgos arqueológicos que se han encontrado. El esfuerzo de arqueólogos e investigadores ha permitido que hoy en día Atapuerca tenga fama mundial y sea un referente importante en el estudio de la Evolución Humana. En el año 2.000, la Unesco declaró este complejo arqueológico Patrimonio de la Humanidad y en 1.997 recibió el Premio Príncipe de Asturias de Investigación Científica y Técnica.

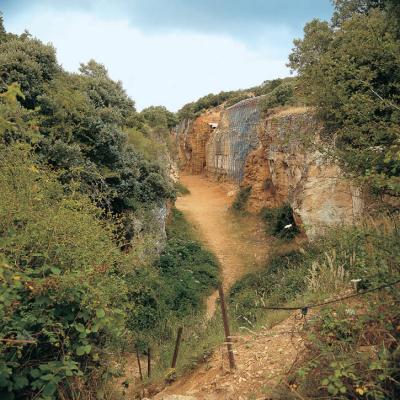

Atapuerca es un sistema kárstico, construido por una serie de galerías y conductos subterráneos. En Atapuerca se han encontrado los yacimientos en Cueva y al aire libre. Los que destacan, bien por su buena conservación o por la relevancia de la información que han aportado a las investigaciones, son los que se sitúan en la Trinchera del Ferrocarril como la Sima del Elefante, la Galeria o la Gran Dolina. Aparte se encuentra la Cueva del Mirador y hay más de 50 yacimientos exteriores y un elevado número de monumentos megalíticos como los dólmenes.

La Sima del Elefante contiene los yacimientos más antiguos encontrados hasta el momento en la zona. En la Galería se han encontrado fósiles de edades comprendidas entre 200.000 y 400.000 años. La Gran Dolina se compone de diferentes niveles con edades comprendidas entre un millón y doscientos mil años. La Cueva del Mirador pertenece a la Cueva Mayor. En la Cueva del Mirador se han encontrados yacimientos que pertenecen a la Edad de Bronce, neolítico y paleolítico superior. En el exterior se han encontrado utensilios líticos que muestran vestigios del paleolítico superior antiguo.

Son muchas las páginas dedicadas a este importante yacimiento. Aquí te incluimos algunas de las que más nos han llamado la atención:

- Fundación Atapuerca. Contiene un interesantísimo espacio didáctico.